戦争のアルゴリズム:武力紛争における意思決定における人工知能の利用 (technconflict.substack.com)

MILTERMでは、軍事における人工知能やアルゴリズム戦といわれるあらたな戦いの側面についての記事を紹介してきているところである。(”https://milterm.com/?s=” の後に探したい言葉を入れると関連記事の検索結果が出ます)今回紹介するのは、One Click From Conflictに10月25日に掲載されていた投稿で、国際赤十字委員会(International Committee of the Red Cross :ICRC)に所属の研究者によるものである。国際人道法(International Humanitarian Law :IHL)の観点から、現状での人工知能活用のリスクを踏まえて論じている。軍事分野へ新しい技術を導入する際の考慮すべきこと等についての議論の一助となればと考える。(軍治)

![]()

戦争のアルゴリズム:武力紛争における意思決定における人工知能の利用

Algorithms of war: The use of artificial intelligence in decision making in armed conflict

By Ruben Stewart Military and Armed Group Adviser, ICRC & Georgia Hinds Legal Adviser, ICRC

2023/10/25

| ルーベン・スチュワート(Ruben Stewart)はジュネーブの国際赤十字委員会(International Committee of the Red Cross :ICRC)で軍事・武装集団顧問を務める。ニュージーランド陸軍将校を経て、近年は人道主義者として、東ティモール、アフガニスタン、イラク、イエメン、シリア、パレスチナ、イスラエル、レバノン、スーダン、南スーダン、エチオピアの現場で20年以上活動。その経験は、紛争環境や特に都市部における武装集団など、武装勢力との関わりや対話を特徴としている。国際赤十字委員会(ICRC)では、武装集団、戦場での行動、国際人道法(International Humanitarian Law :IHL)教育法、将来の紛争傾向、特に技術に関連したものを中心に研究している。国際関係学の修士号を持ち、さまざまな軍事専門誌に多数の論文を執筆している。 |  |

| ジョージア・ハインズ(Georgia Hinds)はジュネーブの国際赤十字委員会(ICRC)で法律顧問を務め、自律型兵器やAI、その他の新しい戦争技術の法的・人道的意味合いについて研究している。以前はフィリピンと太平洋地域の国際赤十字委員会(ICRC)に勤務。国際赤十字委員会(ICRC)入局以前は、オーストラリア政府で国際人道法、人権法、国際刑事法などの国際公法に関するアドバイザーを務める。ブリスベン、シドニー、シンガポールで商法事務弁護士として実務に携わり、オーストラリア陸軍で予備役将校を務めた。オーストラリア国立大学で国際法修士号、グリフィス大学で法学士号(優等)およびジャーナリズム学士号を取得。 |  |

|

*******************************************

人工知能を搭載したソフトウェア・ツール、特に生成AIモデルの驚くべき進歩を反映して、Chat-GPTはわずか1年足らずで有名になった。こうした発展とともに、AIが戦いに革命をもたらすという予測も頻繁に聞かれるようになった。AI開発の現段階では、何が可能かのパラメーターはまだ模索中だが、AI技術に対する軍事的反応は否定できない。

中国の国防白書は、AIの活用が人民解放軍(PLA)の近代化計画の鍵となる戦いの「インテリジェント化」論を推進した。米国サイバーセキュリティ・インフラ・セキュリティ局のジェン・イースタリー(Jen Easterly)局長は、人工知能は「現代で最も強力な武器」になるかもしれないと警告した。また、自律型兵器システムが軍事利用におけるAIの議論を支配する傾向がある一方で、武力紛争における人間の決心(human decisions)をサポートするシステムにおけるAIの利用にはあまり注意が払われていない。

この投稿では、国際赤十字委員会(ICRC)の軍事顧問であるルーベン・スチュワート(Ruben Stewart)と法律顧問のジョージア・ハインズ(Georgia Hinds)が、戦争における武力行為者の意思決定(decisions by armed actors)を支援するために使用される場合の、AIの喧伝される利点のいくつかを批判的に検討しようとするものである。特に、武力紛争における民間人への影響に焦点を当て、民間人の被害軽減とテンポの領域について議論する。

戦争のアルゴリズム:武力紛争における意思決定における人工知能の利用:Algorithms of war: The use of artificial intelligence in decision making in armed conflict

最近騒がれる以前から、皆さんはすでに様々な形でAIを利用しているだろうし、実際、この記事を読んでいるのもAIを搭載したデバイスかもしれない。指紋や顔を使って電話を開いたり、ソーシャル・メディアに参加したり、電話のアプリケーションを使って旅を計画したり、ピザから本までオンラインで何かを購入したりしたことがあれば、それはおそらくAIが関係している。多くの点で、我々はAIに慣れ親しみ、しばしば無意識のうちに日常生活に取り入れている。

しかし、その顔認識ソフトウェアが、攻撃される人物を特定するために使われていたとしたら?もし、目的地まで最も安いフライトを見つける代わりに、同じようなソフトウェアがターゲットを空爆する航空機を見つけるとしたらどうだろう。あるいは、最高のピザ屋や最も近いタクシーを推薦するのではなく、機械が攻撃計画を推薦していたとしたら?これはどうやら、防衛目的でAIベースの決心プラットフォームを開発している企業から「間もなく」出てくる現実のようだ。

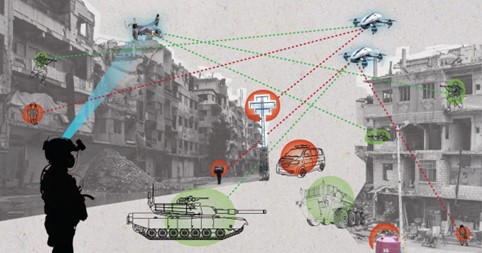

この種のAI決心支援システム(AI decision support systems :AI-DSS)は、AIソフトウェアを使用してデータを表示、合成、および/または分析し、場合によっては戦争における人間の意思決定(human decisions-making)を支援するために推奨、さらには予測を行うコンピュータ化されたツールである。

AI決心支援システム(AI-DSS)の優位性は、しばしば状況認識の向上や意思決定サイクル(decision making cycles)の迅速化という観点から説明される。このような主張は、AIシステムと人間の限界の両方に照らし合わせ、また現代の紛争における計画プロセスの文脈から、以下に解き明かされる。

紛争における民間人への被害リスクの最小化:Minimising risk of harm to civilians in conflict

戦いにおける新技術の登場には、その一体化によって民間人への被害が軽減されるという主張がしばしば伴う(ただし、これは実際には必ずしも裏付けられるものではない)。AI決心支援システム(AI-DSS)の場合、そのようなツールは特定の状況において、紛争中の民間人をよりよく保護するのに役立つと主張されてきた。確かに、国際人道法(IHL)は、攻撃に責任を負う軍の指揮官やその他の者に対し、関連する時点で入手可能なあらゆる情報源からの情報に基づいて決心(decisions)を下すことを義務付けている。

特に市街戦の文脈では、国際赤十字委員会(ICRC)は、民間人や民間物の存在などの要因に関する情報には、インターネットなどのオープンソースのリポジトリを含めるべきだと勧告している。さらに、特にAIと機械学習を考慮して、国際赤十字委員会(ICRC)は、AI決心支援システム(AI-DSS)ツールがこの種の情報をより迅速かつ広範囲に収集・分析することを容易にする限りにおいて、民間人のリスクを最小化するような人間による紛争時のより良い決心(decisions)を可能にする可能性が十分にあると結論づけている。

同時に、バイアスのかかった情報や不正確な情報を防ぐため、AI決心支援システム(AI-DSS)の出力は複数の情報源間でクロスチェックされるべきである。これは紛争中のあらゆる情報源に当てはまることだが、AI決心支援システム(AI-DSS)の場合は特に重要である。国際赤十字委員会(ICRC)が以前に概説したように、システムの機能や人間の利用者が機械とやりとりする方法によって、出力の正確性を検証することは、不可能ではないにせよ、極めて困難な場合がある。これらの側面について、以下に説明する。

システムの限界:System limitations

最近のAI開発に関する報道では、AIが失敗し、時には致命的な結果を招いた例がしばしば取り上げられている。例えば、肌の色が濃い人を認識しなかったり誤認したりするソフトウェア、最新の道路状況を考慮しない旅行ルートを推奨するソフトウェア、自動運転車による死亡事故の例などである。これらの失敗のいくつかは説明可能だが、言い逃れはできない。例えば、出力のベースとなるデータがバイアスがかかっていたり、破損していたり、毒されていたり、あるいは単に間違っていたりするからだ。

このようなシステムも、やはり簡単に「騙す」ことができる。システムを騙してデータを誤分類させる技法が使えるのだ。例えば、敵対的な技法を使って、ターゲッティング支援システムのソースコードに影響を与え、スクールバスを敵の車両と識別させ、壊滅的な結果をもたらすことも考えられる。

AIがより複雑なタスクに使用されるようになり、特に何層もの分析(そして場合によっては決心や判断)が積み重なると、最終的なアウトプットと、最終的なアウトプットに寄与したエラーの原因を検証することはほとんど不可能になる。最初のアルゴリズムによる推薦のわずかな不備が、2番目のアルゴリズムによるプロセスに反映され、歪みを生じさせ、それが3番目のプロセスに反映され、といった具合に。

そのため、AIシステムは、事後的に大規模な分析を行っても、ユーザーや開発者が説明できない振舞いを示すことが多い。有名な大規模言語モデルGPT-4の研究では、数学の問題を解く能力が、3ヵ月後には83.6%からわずか35.2%へと劇的に、そして不可解にも低下していた。予測不可能な振舞いは、強化学習によって生じることもある。機械は、人間を出し抜いたり、出し抜かれたりするために、予期しない、時には否定的な振舞いを取り入れたり、隠したりすることが非常に効率的であることが証明されている。それは、交渉に勝つために嘘をついたり、コンピューター・ゲームに勝つために近道をしたりすることである。

機械と対話する際の人間の課題:Challenges for humans interacting with the machine

AI決心支援システム(AI-DSS)は決心(decisions)を「する(make)」わけではない。しかし、AI決心支援システム(AI-DSS)は、機械と相互作用する際の人間の認知的限界や傾向によるものも含め、人間の決心(decisions of humans)に直接、そしてしばしば大きな影響を与える。

例えば、「自動化バイアス(automation bias)」とは、人間がシステムの出力に対して批判的に異議を唱えたり、特に一刻を争う状況では、矛盾する情報を探したりしない傾向のことである。これは、経験豊富な放射線科医による診断の精度が、誤ったAIの出力によって悪影響を受けたヘルスケアなどの他の分野ですでに観察されている。

医療現場における不正確な診断は命取りになりかねない。武力紛争においても同様で、信頼が致命的な結果をもたらすことがある。2003年、米国のパトリオット・システムは、攻撃ミサイルと誤認して連合軍の友軍機を2度にわたって攻撃した。その後の調査で、重大な欠陥のひとつとして「オペレーターがシステムのソフトウェアを信頼するように訓練されていた」ことが指摘された。

これらの機能が働く方法は、人間と機械の相互作用の特性と相まって、人間の意思決定者(human decisions-maker)の意図とは異なる結果をもたらす可能性を高める可能性がある。戦いにおいては、これは偶発的なエスカレーションを引き起こす可能性があり、いずれにせよ、民間人や被保護者に対するリスクを高めることになる。

テンポ:Tempo

AIの軍事的な優位性点の1つは、敵対者よりも意思決定のテンポ(tempo of decision-making)が速くなることである。そのため、民間人の犠牲を減らすために、「戦術的忍耐」のようなテンポを遅くする技術が採用されている。決心(decision)に必要なプロセスや評価を含め、意思決定のテンポ(tempo of decision-making)を遅くすることで、システムとユーザーの双方に余分な時間ができる。

– より多くを見る

– より多くを理解する

– より多くの選択肢を開発する。

重要なのは、これは最終的な「決心点(decision point)」だけでなく、意思決定の鎖(decision-making chain)全体にわたって当てはまるということだ。したがって、AI決心支援システム(AI-DSS)が「引き金を引く(pull the trigger)」かどうかの最終判断に至るまでの時間のかかるステップをスピードアップすることで、戦術的忍耐の時間を実際に増やす結果になるという主張は、現代の紛争におけるターゲティングと武力行使のプロセスを単純化しすぎる危険性がある。

余分な時間は、より多くを見ることができる:Extra time allows you to see more

2021年8月29日、カブールからの避難中にドローンが空爆され、民間人10人が死亡した事件は、中央軍の司令官によって、「生活パターンを開発したり、その他多くのことをする余裕がなかった」ことが原因だとされた。

「生活パターン」分析とは、攻撃を検討している地域とその周辺における民間人と戦闘員の存在と密度、彼らのスケジュール、移動パターンなどの評価を、一部の軍隊が表現する方法である。これは、民間人の被害を減らすための重要な方法である。しかし、生活パターンの評価は、民間人がそのようなパターンを作り出すのに要する時間、つまりリアルタイムでしか行うことができない。

過去の傾向に基づいて将来の行動を予測しようとしても、現在の状況は反映されない。この例では、古い情報資料、特にカブールのフルモーション・ビデオを見直しても、タリバンによる占領と現在進行中の避難の取組みのために起きている状況や行動の変化は反映されなかっただろう。

「民間人の死傷者防止指針(civilian casualty prevention guidance)」が説明しているように、「長く待って観察すればするほど、何が起こっているのかがわかり、致死的手段や非致死的手段を用いる決断を下す準備ができる」、あるいはナポレオンが言ったように「ゆっくり服を着せてくれ、私は急いでいる」。このことは、意図的に物事を行うことで、最良の結果が得られることがあるということである。

余分な時間は、ユーザーがより多くを理解することを可能にする:Extra time allows a user to understand more

意思決定のテンポ(tempo of decision-making)を遅くするもう一つの理由は、特に複雑で混乱した状況に対する人間の理解力を高めるには、適切な対応を熟慮するだけでなく、時間がかかるからである。利用できる時間が少なければ、状況を理解する人間の能力も低下する。軍事計画策定のプロセスは、指揮官や参謀が作戦環境、敵対者、友軍部隊、民間人、検討中の行動方針の長所(advantages)と短所(disadvantages)を検討する時間を与えるようにデザインされている。

ドワイト・D・アイゼンハワー(Dwight D. Eisenhower)将軍が「会戦の準備において、計画は役に立たないが、計画策定は不可欠であることを私は常に発見してきた」と説明しているように、この検討プロセスから得られる理解は外注する(outsourced)ことはできない。

このことは、人間の意思決定者(human decisions-makers)がAI決心支援システム(AI-DSS)によって生成された、あるいは「推奨(recommended)」された行動方針(course of action)を検討する場合にも意味を持つ。AI決心支援システム(AI-DSS)の能力は、対戦相手と比較して作戦のテンポを加速させるものであり、AI決心支援システム(AI-DSS)が活用される最も大きな理由であろう。AI決心支援システム(AI-DSS)によって提案された計画を策定するプロセスを引き受けることなく、あるいは完全に理解することなく、人間の計画担当者は状況、さまざまな影響要因、関係する行為主体について限られた理解しか持っていない可能性が高い。

実際、自動化された補助装置の使用は、人間の使用者の警戒心を低下させ、状況認識を維持する能力を損なう可能性があることが観察されている。ターゲットを確認するために実行可能なあらゆることを行うという義務は、その周囲の状況下で可能な限り包括的な状況認識を得るために、利用可能なインテリジェンス、監視、偵察アセットを最大限に活用するという要件を示している。

余分な時間は、ユーザーがより多くの選択肢を開発することを可能にする:Extra time allows a user to develop more options

指揮官がより多くのものを見たり、理解したりできるようになるだけでなく、余分な時間があれば、指揮官は戦術的な代替案を練ることができる。これには、武力を行使しないことエスカレーションに持ち込まないことの決心も含まれる。余分な時間があれば、他の部隊やプラットフォームが離脱し、再配置し、補給を行い、計画を立て、次の作戦を支援する準備をすることができる。

これによって指揮官は、民間人への被害をより軽減できるような代替案を含め、より多くの選択肢を得ることができる。余分な時間があれば、警告の発出などの緩和策を追加できるかもしれないし、民間人の立場からすれば、避難場所を確保したり、食料や水を補給したり、避難したりといった対処法を実行することができる。

軍事計画策定のドクトリンの一例が説明するように、「時間があり、より迅速に行動することに優位性がないのであれば、十分な計画を立てる時間をとらないことの言い訳はほとんどできない」。NATOの民間人保護ハンドブックにあるように、「国際人道法(IHL)の原則に従って、部隊や物体を意図的に計画し、識別し、正確にターゲットにする時間があれば、民間人犠牲者(civilian casualties :CIVCAS)の可能性は大幅に最小化される」。

結論Conclusion

「戦争は混沌としており、致死的であり、基本的に人間の営みである。戦争とは、人間同士、あるいは人間同士の意志のぶつかり合いである。すべての戦争は本質的に人間の振舞いを変えるものであり、それぞれの側が武力によって相手の行動を変えようとする」。戦争は人間の意見の相違から生じ、人間の集団の間で行われ、人間によって支配され、人間によって終結する。最も重要なことは、紛争の苦しみは人間が負うということだ。

このような現実、そして実際に国際人道法(IHL)そのものが、武力紛争におけるAIの開発と使用に対して「人間中心(human-centered)」のアプローチを求めているのである。このようなアプローチには、少なくとも2つの重要な側面がある。(1)影響を受ける可能性のある人間に焦点を当てること、(2)AIを使用する、あるいは使用を命じる人間の義務と責任に焦点を当てること、である。

影響を受ける可能性のある人たちに目を向けると、軍事的優位を得るためにAI決心支援システム(AI-DSS)を使用する際、民間人に対するリスクを軽減することだけでなく、民間人保護の目標に特化したツールをデザインし、使用する可能性もある。この点で提案されている可能性には、民間人の存在を認識し、追跡し、部隊に警告するツールや、武力紛争で保護されていることを示す特徴的な紋章を認識するツールなどがある(「AIを活用して民間人への被害を軽減(Leveraging AI to Mitigate Civilian Harm)」と「業界との関わり:市街戦における新技術に国際人道法(IHL)を一体化する(Engaging with the industry: integrating IHL into new technologies in urban warfare)」を参照)。

そして、人間が国際人道法(IHL)の下での義務を果たすことができるようにするということは、武力紛争における人々の生命と尊厳にリスクをもたらす決心(decisions)において、AI決心支援システム(AI-DSS)は人間の判断に情報を与えるべきだが、それに取って代わることはできないということである。このことは、自律型兵器システムの文脈で、国家によって広く認識されている(例えば、「自律型致死兵器システム(LAWS)に関する国際法的文書の提案(Proposal for an international legal instrument on Lethal Autonomous Weapons Systems (LAWS))」、「人工知能技術を使用した兵器システムの開発と使用の分野におけるロシア連邦軍の活動の概念について(On the Concept of the activities of the Armed Forces of the Russian Federation in the field of development and use of weapons systems using artificial intelligence technologies)」、「自律型兵器システムに関する規範と運用の枠組みに関するパレスチナ国の提案(State of Palestine’s Proposal for the Normative and Operational Framework on Autonomous Weapons Systems)」を参照)。

国際人道法(IHL)を遵守する責任は、コンピューターではなく、個人とその指揮官にある。米国国防総省の戦争法マニュアルにあるように、「戦争法は、兵器が法的判断を下すことを必要としない……むしろ、戦争法を遵守しなければならないのは人間である」。中国は新世代人工知能の倫理規範の中で、この点をより一般的に強調し、「人間は、最終的な責任主体である」と主張している。

AI決心支援システム(AI-DSS)が民間人の保護と国際人道法(IHL)遵守の向上につながるという主張は、システムの限界、人間と機械の相互作用、作戦のテンポ向上の効果についてわかっていることを考慮に入れながら、批判的に異議を唱え、これらの考慮事項に照らして評価されなければならない。