認知戦と組織のデザイン:AIを活用した軍事意思決定の再構築 (National Defense University Press)

昨年11月に開催された防衛装備庁の「防衛装備庁技術シンポジウム2025」の内容が1月16日に公開された。中には、「戦闘支援AIの実現に向けた研究」、「意思決定迅速化技術の研究」の様な防衛省が取り組んでいる人工知能の研究もその一端を知ることができる。欧米の軍隊でのAI適用などと比較して日本はどのくらい進んでいるのかを知る一つの情報とはなるであろう。

今回紹介するのは、National Defense University Press のサイトに掲載のAIを軍事の世界に適用する際のハードルの高さを考えさせられる論文である。

これまでもMiltermでは軍事にAIを適用することを主題にした内容を紹介してきている。

単純にOODAル-プに適用するとは言うものの、人間が行っていた活動をAIに肩代わりさせるということでは、リスクを予測できないのではないかと感じた次第である。

この論稿では、AI適用のために軍の行動を人の認知的活動として、軍隊の指揮・幕僚活動のプロセスを理解するところから始まる例を扱っている。現在行われている指揮・幕僚活動での認知習慣(cognitive habits)をつまびらかにしておかないと、何をAIに委ねてよいのかどうかを判断することすらできない。

よく読むと表題に「認知戦(cognitive warfare)」とあることの意味が分かってくる。それほど長い論考ではないが、多くの示唆を与えてくれる内容である。(軍治)

![]()

認知戦と組織のデザイン:AIを活用した軍事意思決定の再構築

Cognitive Warfare and Organizational Design: Leveraging AI to Reshape Military Decisionmaking

Jan. 9, 2026

By Michael S. Silver, Kellen D. Sick, Matthew A. Snyder, and Justin E. Farnell

マイケル・S・シルバー(Michael S. Silver)米海軍大佐はMH-60のパイロットであり、米艦船(USS)セオドア・ルーズベルトの副長候補である。

ケレン・D・シック(Kellen D. Sick)米空軍大佐はF-15のパイロットであり、統合参謀本部J7の統合戦力開発戦略官を務めている。

マシュー・A・スナイダー(Matthew A. Snyder)米陸軍少佐は特殊部隊将校であり、南方特殊作戦コマンドの第3部副部長(Deputy J3)を務めている。

ジャスティン・E・ファーネル(Justin E. Farnell)海兵隊少佐は海兵隊のMV-22オスプレイのパイロットであり、現在統合参謀本部第6部(J6)統合評価部に所属している。

2025年3月15日、カリフォルニア州フォートアーウィンで行われたプロジェクト・コンバージェンス・キャップストーン5実験において、兵士が様々なロボットと連携して人間機械統合フォーメーションで戦う様子(米陸軍/パトリック・ハンター(Patrick Hunter)撮影) |

2002年、オークランド・アスレチックスは大きな課題に直面した。年俸総額がニューヨーク・ヤンキースの1億2,590万ドルの3分の1にも満たず、主力選手の退団も重なり、苦戦が予想されていた。しかし、彼らはスター選手を擁した2001年の快進撃を凌ぎ、アメリカン・リーグ西地区で優勝を果たした。マイケル・ルイス(Michael Lewis)の著書「マネーボール(Moneyball)」に着想を得た映画で永遠に記憶されるアスレチックスの2002年シーズンは、データに基づく意思決定を活用して現状打破を試みたケース・スタディと言えるだろう。過小評価されていた指標を優先することで、オークランド・アスレチックスはわずかなコストで、ヤンキースと並ぶリーグ最多勝利数を誇るチームを築き上げた。2004年には、ボストン・レッドソックスがこのアプローチを採用し、86年間続いた優勝から脱却した。これは、データ中心の分析(data-centric analysis)が意思決定においていかに競争力を発揮するかを示す好例である。2002年のオークランド・アスレチックスがデータを活用して従来型のアプローチに挑戦したように、現代戦(modern warfare)では直感に基づく意思決定(intuition based decisionmaking)から人工知能/機械学習(AI/ML)を活用した意思決定(AI/ ML–enabled decisionmaking)への移行が求められている。統合部隊は、20年前の野球のように、喫緊の課題に直面している。AI/MLを統合しなければ、より機敏な敵対者に出し抜かれるリスクを負うことになる。

ソ連崩壊後の合衆国の軍事的・経済的支配性(military and economic dominance)は、敵対者に大規模な従来型の戦い(conventional warfare)からの戦略転換を迫った。彼らは代わりに、心理ドメイン、情報ドメイン、そして技術ドメインを駆使して戦略的優位性を削ぎ、認知戦(cognitive warfare)を通してアメリカの意思決定に挑むことにますます重点を置くようになった。伝統的な戦い(traditional warfare)とは異なり、認知戦(cognitive warfare)は個人や組織が現実を認識し、選択肢を評価し、情報に基づいて行動する方法を形作る[1]。ロシアによる2016年の合衆国大統領選挙への介入やイギリスのEU離脱投票、そして中国による2024年の台湾総統選挙へのTikTokを用いた影響は、認知戦が近年の歴史に及ぼした深遠な影響を如実に示している[2]。さらに、中国は自律性(autonomy)が支配する未来の戦場を積極的に追求しており、意思決定を数秒から数ミリ秒へと短縮するAI/MLツールで敵対者を凌駕している[3]。

中国発のDeepSeek AIや合衆国を基盤とするChatGPTといったツールの普及は、決心サイクル(decision cycles)を加速させ、民間部門と商業部門に革命をもたらした[4]。これらのツールは、膨大で複雑なデータ・セットを数秒で分析し、かつてはアナリスト・チーム全体が長期間にわたって作業する必要があったような洞察を生み出すことができる。例えば、JPモルガン・チェース(JPMorgan Chase)はAIツールを用いて、数百万の口座の不正行為を検知し、信用リスクをほぼリアルタイムで評価している。また、米国立気象局(U.S. National Weather Service)はMLモデルを用いて衛星画像と大気データを迅速に処理し、より早く正確な嵐の予報を行っている[5]。これらのシステムは、人間の認知負荷(the human cognitive load)を軽減し、迅速かつ高品質な決心を大規模に可能にする。金融や公共の安全をはるかに超えるリスクを伴う国家安全保障の分野では、意思決定のスピードと正確性における競争優位性がこれまで以上に重要になっている。この種の競争では、ナラティブを形作り、情報を操作し、競争者よりも速く優れた決心を下すことができる者が勝利を収める[6]。

AI/MLへの広範な投資と実験にもかかわらず、ほとんどの組織はこの技術によるパフォーマンス向上に苦戦している。AIを実験している企業のうち、真の価値を生み出しているのはわずか4分の1に過ぎず、大規模なAI機能を構築している企業は5%未満である[7]。Microsoftのような大企業でさえ、変革を実現していると認識しているが、AIをプロセスの高速化に活用しているだけで、業務を根本的に改革してパフォーマンスを最適化するには至っていない[8]。ai.milに掲載されている取り組みからもわかるように、国防総省(Department of War :DOW)はAI/ML機能に数十億ドルを投資してきた。しかし、この技術へのアクセスだけでは、大規模な統合には不十分であることが証明されている。課題は技術的なものだけでなく、行動的なものである。真のAI統合(AI integration)には、技術以上のもの、つまり導入が必要である。これらのAIの課題がなぜ解決されないのかを理解することは、実行可能なソリューションを特定し、戦略的優位性の喪失を防ぐために不可欠である。全組織の4分の3がまだAIの具体的なメリットを実感していないため、導入の課題は、AI/MLの潜在能力を最大限に引き出すために、構造、プロセス、そして人材を改革することである[9]。国防総省(DOW)は現状に注目して打開し、AI/MLの導入を加速して意思決定を強化する必要がある。2025年2月にパリで開催されたAIアクション・サミットで、北大西洋条約機構(NATO)の変革担当最高同盟軍司令官、ピエール・ヴァンディエ(Pierre Vandier)提督は、この必要性を明確に表明した。「人工知能は軍事上の意思決定を大幅に加速しており、対応できない軍隊はリスクを負って負けることになる。[10]」ウクライナ紛争を例に挙げ、現状維持のリスクが高いことを強調した。「迅速かつ大規模に適応しなければ、死ぬことになる[11]。」ヴァンディエ(Vandier)提督が変革担当最高同盟軍の将校にAI訓練を義務付けたことは、能力ではなく導入が統合の制限要因であるという重要な洞察を強調している。

本稿では、国防総省(DOW)の意思決定におけるAI/MLツールの広範な導入に影響を与える組織デザイン要因を分析する。認知戦の攻勢的適用と防勢的適用、AI/MLツールの利用に関する倫理的配慮、信頼と透明性の要件、AI/MLツールの利用が敵対者に及ぼす可能性のある脆弱性については、本稿では取り上げない。これらの分野は、今後の研究機会となる。

組織デザインの分析へのアプローチ

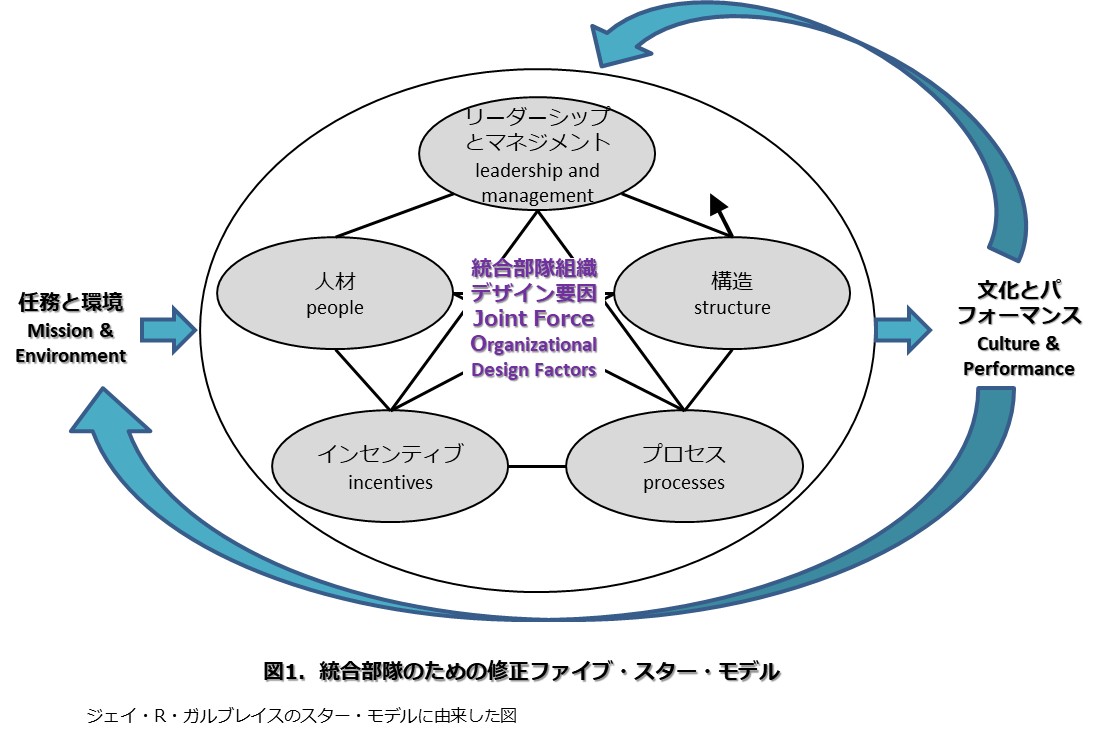

組織が変曲点に達し、現状維持が最終的に停滞または衰退につながると判断した場合、組織デザインを適応させる必要がある。ジェイ・ガルブレイス(Jay Galbraith)のスター・モデルは、組織デザインへの戦略的アプローチとして1977年に初めて導入され、このような適応に役立つフレームワークを提供している[12]。この記事では、ガルブレイス(Galbraith)のスター・モデルを修正して、国防総省(DOW)の意思決定へのAI/MLツールの広範な導入に影響を与える組織デザイン要因を分析する。これらの要因は、戦闘、リソース確保、管理目的で、戦術的、運用的、戦略的組織全体に適用できる。図1に示す修正されたスター・モデルには、「人材(people)」、「構造(structure)」、「プロセス(processes)」、「インセンティブ(Incentives)」、「リーダーシップとマネジメント(leadership and management)」という5つの組織デザイン要因が含まれている。

用語の「人材(people)」とは、組織の目標を達成するために個々の労働者に求められる考え方、スキル・セット、そして才能を指す[13]。構造とは、意思決定権の所在を指す。用語の「構造(structure)」は組織の形態を定義し、決心が行われる内容(what)と場所(where)を通して、権限の階層構造と権力の配分を反映する[14]。用語の「プロセス(processes)」とは、意思決定に繋がる情報の流れを指す[15]。用語の「インセンティブ(Incentives)」とは、組織目標を達成するために、特定の構造の中で人材がプロセスを実行するよう促す動機付けツール(the motivational tools)である[16]。インセンティブは、外発的動機(extrinsic motivators)と内発的動機(intrinsic motivators)の組み合わせを反映する。用語の「リーダーシップとマネジメント(leadership and management)」は、統合の指導者(joint leaders)が組織の戦略的方向性と優先事項を確立する上で果たす役割を反映している。これらは、組織デザインにおける他の要因に大きな影響を与える[17]。

これら5つの要因は、組織デザインにおける相互依存的なノードとして機能し、組織全体の強みを強化または弱める。これらの要因がどのように相互作用するかが、組織のパフォーマンスと文化的成果を左右する。任務や環境の変化が修正スター・モデルの1つのノードに変化をもたらした場合には、組織は進化し、適応してデザイン要因を再最適化する必要がある[18]。そうしないと、組織が無力化したり、さらには陳腐化したりするリスクがある。

|

組織デザイン要因の分析

人材(people)。人間の脳の生理機能だけでなく、組織内の人材の考え方やスキル・セットも、AI/MLの導入に影響を与える重要な要因である。意思決定は、経験と反復によって形成される相互に関連した認知プロセスに依存する。時間の経過とともに、使い慣れたワークフローが深く根付き、新しいツールが利用可能になったとしても、人々はデフォルトのパターンに頼るようになる[19]。これは統合部隊において顕著で、数十年にわたるインターネットの使用によって、人は「検索エンジンの思考の癖(search-engine mindset)」を身につけている[20]。この習慣化されたアプローチは、インデックス化された静的なキーワード駆動型の相互作用を通じて結果を生成することに依存している。対照的に、AI/MLツールは、反復によって改善される、動的で文脈に応じた応答を生成する。

AI/MLを効果的に導入するには、人間の認知習慣(human cognitive habits)を根本的に変える必要がある。軍事計画者が実行前に初期のコンセプトを何度も繰り返し洗練させるのと同様に、AIが生成するアウトプットも最適な結果を得るために同様のプロセスを必要とする。しかし、多くのユーザーはAI/MLをインタラクティブなツールではなく静的なクエリ・システムとして扱うことで、その有効性を無意識のうちに制限している。従来の検索エンジン・ワークフローへの依存は、AI/MLの適応的な性質と相反する行動を助長してきた。従来型の検索と応答モデル(conventional search-and-response model)でAI/MLにアプローチするユーザーは、技術が従来とは異なる形式の相互作用を要求すると苦労する。応答が不完全であったり、「幻覚」のようなエラーが含まれていたりすると、ユーザーはフラストレーションを感じ、技術から離れてしまうことがよくある[21]。ニューヨーク大学スターン経営大学院のチーフAIアーキテクト、コナー・グレナン(Conor Grennan)は、「脳がAIの使い方を知らないのではなく、それよりも厄介な問題がある。脳はAIの使い方を知っていると思い込んでいるのだが、それは間違っている」と指摘している[22]。課題は単に新しいツールを学ぶことではなく、深く根付いた認知習慣(cognitive habits)を再訓練することである。

他の兵器システムと同様に、AI/MLは既存の機能を置き換えるのではなく、補完する専用ツールである。その潜在能力を最大限に引き出すには、AI/MLを検索エンジンのように扱うのではなく、AI/MLが生成する出力を積極的に形作るように変革する必要がある。例えば、「統合部隊任務の作戦計画を策定する」というGoogleクエリを実行すると、静的なテンプレートとアーカイブされた作戦命令(OPORD)が表示される。これらのリソースは有用だが、動的な任務要件を満たすには何時間もの手動調整が必要である。一方、生成型AI/MLモデルを反復処理することで、ユーザーは任務固有の入力に合わせて完全にカスタマイズされた作戦命令(OPORD)を迅速に作成できる。これらの入力が提供されると、AI/MLはリアルタイムのインテリジェンスを分析し、敵部隊の位置、脆弱性、そして考えられる行動方針(COA)を特定できる。気象予報を組み込むことで、作戦への影響を評価し、部隊の移動、兵站、緊急事態への対応を推奨できる。この反復プロセスは、計画策定プロセスを大幅に加速させる可能性があり、計画策定期間を数日から数時間に短縮し、より迅速かつ情報に基づいた決心を可能にする。

カリフォルニア州ペンドルトン海兵隊基地で、第1海兵師団第5海兵連隊第3大隊のインテリジェンス専門家であるエリック・グラナドス(Eric Granados)海兵隊伍長が、小型無人航空機システム訓練の一環として、人工知能搭載システム「デッド・センター」でRQ-20プーマを発進させる様子。 2025年8月20日(米海兵隊/トレント・A・ヘンリー(Trent A. Henry)撮影)。 |

新たな認知習慣(cognitive habits)を身につけることは、課題の一部に過ぎない。AI/MLを効果的に導入するには、必要なスキルを習得するための体系的な訓練が必要である[23]。最近の調査によると、訓練を受けていないユーザーは、AIを検索エンジンのように扱っていたために、本来の能力を超えてAIを適用した際にパフォーマンスが低下した。対照的に、訓練を受けたAIユーザーは、生産性と品質の両方で大幅な向上が見られた。通常、平均パフォーマンス閾値を下回る個人の場合、効果的なAI拡張によってパフォーマンスが43%向上した。すでに平均パフォーマンス閾値を超えてパフォーマンスを発揮している個人でも、効果的なAI拡張によって17%の向上が見られた。さらに、訓練を受けたAIユーザーは、AI拡張を受けていないユーザーよりも12%多くのタスクを完了し、作業速度が25%向上した[24]。これらの調査結果は、運用効率を最大化するために、計画的なAI/ML訓練が必要であることを強調している。

AI/ML訓練は、迅速なエンジニアリング、反復と連鎖、ロール・ベースの相互作用、会話によるエンゲージメントといった主要なスキル・セットにおける技術的熟練度の向上にとどまらない。適応を促す認知的・行動的メカニズムも考慮に入れる必要がある。訓練は、パフォーマンスの向上が継続的な使用を促し、最終的には新しい習慣の形成につながるような、正のフィードバック・ループを強化する必要がある。この変化を実現するには、従来の方法に見られる構造化された強化戦略の欠如を修正するための、意図的な実装努力が必要である。行動変容には、実践的な訓練、反復学習、そしてリーダーシップ主導の導入イニシアチブの組み合わせが必要である。訓練・プログラムは不可欠であるが、導入はAI/MLツールを組織構造に適合させることにも左右される。

構造(Structure)。組織構造は、どのような決心(what decisions)がどこで行われるかを決定し、AI/MLの導入に直接影響を及ぼす。組織の任務と環境が構造のデザインを左右する一方で、構造の違いは、意思決定におけるAI/MLツールの活用速度、効率、有効性に影響を与える。組織がどのような決心を行うかを理解することで、AI/MLツールの活用方法が明らかになる。決心が行われる場所を特定することで、それらをどこに適用すべきかが明らかになる。

決心は、その性質や複雑さが大きく異なる[25]。会議の記録を要約して配布するなどの管理タスクは、新たなターゲティング情報や部隊の態勢に基づく動的な戦場評価とは大きく異なる。異なるタイプの決心には、異なるAI/ML統合モデルが必要である。変動性や予測不可能性が高いタスクには、より協調的なアプローチが必要である。対照的に、構造化され、反復可能な決心では、より自動化できる。一般的なモデルには、完全な委任、相互作用、集約などがある[26]。完全な委任では、AI/MLツールは人間の介入なしに決心を行う。相互作用では、人間とAI/MLツールは、一方の意思決定者の出力がもう一方の意思決定者に入力を提供するように、順番に決心を行う。「Project Maven」によるターゲティング・サイクルの拡張は、この相互作用モデルの例である。このモデルはさらに「ケンタウルス(Centaur)」アプローチと「サイボーグ(Cyborg)」アプローチに細分できる。「Centaur」アプローチは、相対的な強みに基づいて人間とAIのタスク分割を推進する。「Cyborg」アプローチは、人間とAIの意思決定をリアルタイムで融合させ、AIを活用して継続的な分析と適応を行いながら、文脈に基づいた判断(context-driven judgments)については人間の監督を維持する[27]。集約においては、人間による決心(human-based decisions)とAIによる決心(AI-based decisions)はそれぞれ独立して行われ、それぞれの強みに基づいて委任された後、集合的決心(collective decision)へと集約される。このモデルでは、AI/MLツールは意思決定プロセスにおける投票メンバーとなり、多くの場合、様々な基準に基づいて重み付けされる。各モデルは、特定の決心の種類に合わせて、人間とAI/MLの能力の異なるバランスを反映している[28]。

決心の種類(the type of decision)に加えて、意思決定権の配分(決心が行われる場所)がAI/MLツールの最適な配置を決定する。任務と環境は、通常、複数の構造タイプにわたってこの配分を左右する。標準化を重視する組織は、中央集権的な意思決定(centralized decisionmaking)を行う専門的または機械的な官僚制(machine bureaucracies)へと傾倒する傾向がある。半自律的な部隊(semiautonomous units)間で標準化されたアウトプットを求める組織は、「部門化(divisionalized)」された構造を形成する。プロジェクト・ベースの適応的なアウトプットが不可欠な組織は、よりフラットな分権型権限(decentralized authority)を持つ流動的な構造であるアホクラシー(adhocracies)※1の恩恵を受ける[29]。いずれの場合も、AI/MLツールは意思決定が行われる場所に統合されるべきである。任務と環境が構造的な柔軟性を許容する場合、分権型の意思決定(decentralized decisionmaking)は、より低いレベルでより迅速かつ適応的な対応を可能にすることで、AIの効果を高めることができる。例えば、ウクライナは最近、AI/MLツールを備えた「Palantir」社のエンジニアを最前線部隊に配置し、戦場での迅速な意思決定を可能にした[30]。

※1 「アドホクラシー(adhocracy)」とは、「Ad Hoc(臨時の、その場限りの)」と「-cracy(制度、体制)」を組み合わせた造語で、特定の状況に応じて柔軟に組織や手段を変化させる、一時的で流動的な体制や考え方を指す。従来の固定的な「官僚制(bureaucracies)」に対比する概念として、未来学者のアルビン・トフラーが提唱した。

AI/MLツールは、広範囲に相互接続されたデータソースにアクセスする際に最大限のパフォーマンスを発揮する。そのため、AI/MLの統合は、分野を横断した多様な入力情報を統合する、迅速に構成・分解可能な機能横断チームにおいて特に効果的である。例えば、電子戦(electronic warfare)とサイバースペースの融合においては、サイバーセキュリティ、シギント(SIGINT)、運用担当者が孤立したサイロで運用するのではなく、緊密に連携することで、AIを活用した脅威検知が最も効果的になる。

逆に、高度に中央集権化された構造(highly centralized structures)では、AI/MLツールはリアルタイム運用におけるアクティブなコンポーネントではなく、単なるアドバイザー的な役割に限定される可能性がある。また、形式化された階層構造は、効果的な導入に必要な組織能力の育成を妨げる可能性がある[31]。それでも、国防総省(DOW)のような指揮命令系統の階層構造は、可能な限り意思決定の垂直的分権化(vertical decentralization)または水平的分権化(horizontal decentralization)を高めることでメリットを得ることができる。組織は、効率性のための内部的な一貫性の維持と環境変化への適応との間で、根本的な緊張関係に直面している。官僚主義(bureaucracies)は、標準化においては効率的であるにもかかわらず、迅速な適応に苦労することがよくある[32]。このような組織構造は進化が遅く、適応を必要とする変化する環境に追いつけないことがよくある。組織は、構造的適応と内部的な一貫性のバランスを取り、決心の種類(the type of decision)に応じてAI/MLツールを実装し、AI/MLツールがスピード、洞察力、決心の優越性(decision superiority)を最も効果的に高める場所にAI/MLツールを配置する必要がある[33]。

プロセス(Processes)。AI/MLツールを意思決定に導入するかどうかは、決心の内容と場所だけでなく、決心の方法にも左右される。プロセスとは、組織内における情報の流れを上下左右に形作る相互に関連した活動である[34]。プロセスは、協業(collaboration)、調整(coordination)、組織的意思決定を促進し、AI/MLツールがこれらの情報の流れをどのように強化するかに影響する。プロセスは、任務達成のために内部境界間のあらゆるレベルの協業(collaboration)が必要な場合、階層型構造(hierarchical structure)と分権型構造(decentralized structure)の両方に適用される[35]。統合部隊にとって、不確実性、時間的制約、敵対者からの対抗措置といった状況下で、非公式プロセスと公式プロセスがシームレスに機能する必要がある。

|

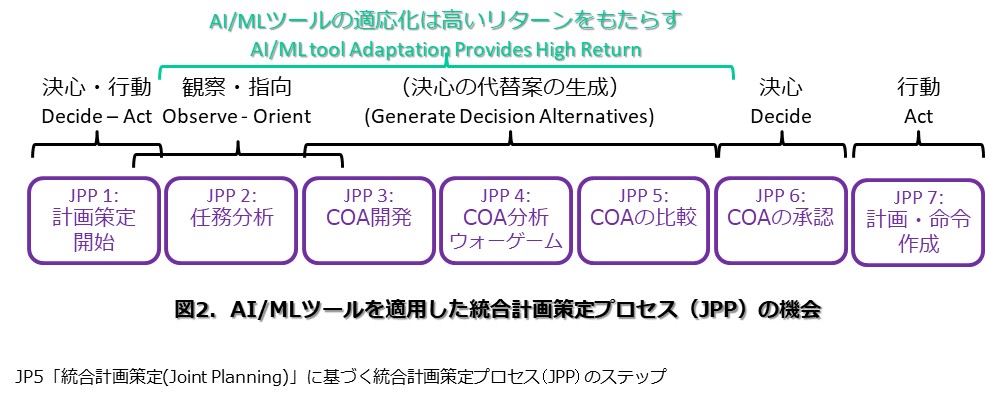

意思決定は複雑ではあるものの、リンクされた情報フローのサイクルである[36]。ジョン・ボイド(John Boyd)のOODAループ(観察、指向、決心、行動)は、このプロセスを簡略化するのに役に立つ。空中戦のニーズから生まれたOODAループは、敵がこのループを巡る速度よりも速く循環することで、戦闘において優位性を生み出すと主張している。コンセプト的には、ボイド(Boyd)の考えは、認知戦におけるAI/MLツールの活用に説得力がある。観察と方向づけのステップでは、行動主体は情報を収集・認識し、環境、脅威、機会、リスクに関するメンタル・モデルを構築する。暗黙のステップとして、決心の代替案(decision alternatives)を生成し、それらの代替案を比較検討した上で、1つを選択し(決定ステップ)、実行する(行動ステップ)[37]。この簡略化されたフレームワークを踏まえると、AI/MLツールは、観察・方向づけプロセスや決心の代替案(decision alternatives)の生成と比較に非常に適している。統合計画策定プロセス(JPP)を代表的な軍事意思決定プロセスとして用いることで、これらの可能性が浮き彫りになる(図2参照)。

統合計画策定プロセス(JPP)は、最も凝縮された形では、複数の機能にまたがって実行される一連の情報フローであり、成果物と参謀の行動を生み出し、指揮官の決心につながる。ドクトリン的には、統合計画策定プロセス(JPP)は指揮官、計画策定参謀、そして下位階層間の計画策定における相互作用を促進する[38]。このフレームワークは、評価に基づいた再帰的なプロセスであり、計画担当者が後の段階で発見した問題が、それ以前の段階の調整を促す。指揮官は、状況や利用可能な時間に応じて、7つの段階を短縮、変更、または同時に実行することができる[39]。

計画策定を開始するには、指揮官は環境の変化の傾向を認識、監視、そして対応する手段を持たなければならない。指揮官がこの機能を集中管理すると、顕著な傾向を見逃すリスクがある。しかし、この機能を分散化(disaggregating)すると、プロセスの必要性が高まる。以前は、組織が大規模になり、プロセスが分散化(disaggregated)されるほど、意思決定に必要な人員(manpower)が増加し、決心サイクル(decision cycles)が遅くなっていた。AI/MLツールは、より広範なデータ・セットからより高速なパターン認識とセンシング・インサイト(sensing insights)を提供することで意思決定プロセスを加速させ、事後対応型ではなくプロアクティブな計画策定を可能にする[40]。例えば、AI/MLツールは生のインテリジェンス・データを迅速に分析し、人間が定義した閾値を超える変化をハイライトすることで、手作業によるデータ分析の必要性を減らし、人間が批判的思考と創造的思考に集中できるようにする[41]。

計画策定が開始されると、AI/MLはインテリジェンス源と戦力即応性報告を統合し、統一された作戦図を作成することで、データ集約型の任務分析(data-intensive mission analysis)を加速する。これは、問題の枠組みを定め、行動方針(COA)策定を導く上で非常に重要である。これまで、これらの入力は個別に処理・可視化され、参謀の直接的な介入が必要だったため、指揮官が作戦環境と解決すべき軍事的課題の包括的な全体像を把握することは困難だった。しかし、AI/MLツールを活用することで、計画担当者はテラバイト規模のデータを処理し、人間が定義したパラメータに基づいて情報を迅速に表示することができる。また、AI/MLツールは、意思決定者が検討するための複数の可視化オプションを提供することもできる[42]。

ジェネラル・アトミックス社との提携により開発された無人戦闘機YFQ-42A共同戦闘機(Collaborative Combat Aircraft)が、2025年8月27日にカリフォルニアで飛行試験を実施した(ジェネラル・アトミックス社提供)。 |

このステップの後、計画担当者は指揮官の承認を得るために決心の代替案(decision alternatives)を開発する必要がある。統合計画策定プロセス(JPP)では、これには行動方針(COA)の策定、行動方針(COA)の分析とウォーゲーム、そして行動方針(COA)の比較が含まれる。この段階で、計画策定は批判的思考から創造的思考へと移行する。しかしながら、計画担当者は現在、チームの専門知識と経験に制約された手作業による反復的な手法を用いて解決策を考案し、PowerPointなどの時代遅れの視覚化ツールを使用して結果を提示している。AI/MLツールは、異なる機能やソースから大量のデータを集約し、より迅速かつ幅広い視点から複数の行動方針(COA)を作成できるようにすることで、個人の専門知識や手作業による反復的な検討への依存を軽減する。

計画担当者は、AI/MLツールを使用して、潜在的な敵対者、中立者、および友軍の反応を評価する際に、独自のペルソナを想定できる。適切な入力があれば、AI/MLツールは「レッド・チーム」のロールプレイングも実行でき、戦争ゲームの反復プレイを高速化する。これらのツールは、行動方針(COA)の強み、弱み、およびリスクを特定するために必要な背景分析を容易にする。計画担当者は、指揮官の優先順位、制約、および制限に基づいて、AI/MLツールを使用して複数の行動方針(COA)を評価することもできる[43]。これらのAI/MLツール統合の機会により、計画担当者は行動方針(COA)を比較、改良、および評価し、指揮官への行動方針(COA)推奨を裏付ける分析を深めることができる。AIによって生成された行動方針(COA)は強力であるが、計画担当者はそれに過度に依存せず、機械によって生成されたオプションが人間の判断、作戦上の文脈、および指揮官の意図によってフィルタリングされるようにする必要がある。前述のように、AI/MLツールは、軍事的意思決定の基盤となる反復的な認知プロセスを置き換えるのではなく、補強するものであるべきである。

指揮官が行動命令(COA)を選択すると、計画担当者はAI/MLツールを用いて指揮官に代わって計画と命令を起草し、配布することができる。AI/MLツールは、指定されたフォーマットに基づいて、幅広い入力から出力を作成できる。現在、計画と命令の作成プロセスには、計画策定中に行われた分析と意思決定を書き写し、作戦命令(OPORD)などの成果物を作成するという、手作業に重点を置いた作業が含まれている。

AI/MLツールを統合計画策定プロセス(JPP)に統合することは、AI/ML対応プロセスが機械速度で情報フローの有効性を高める多くの機会のほんの一例である。AI/MLツールは、意思決定者が最適な選択肢を選択する前に、観察と方向付けを行い、幅広い決心の代替案(decision alternatives)を開発する能力を高め、洗練、比較、評価を行う。他のプロセスでは、AI/MLツールがサポートする情報フローを認識し、その使用を最適化することが導入の課題となる。インテリジェンスの合成と集約、そして戦力即応性評価といった予測可能で反復可能なプロセスは、AI/MLツールを用いたより自動化された決心に適している。任務分析、敵対者モデリング、行動方針(COA)策定といった曖昧、反復的、あるいは創造的なプロセスは、前述のCentaurやCyborgアプローチのような相互作用モデルに適している。行動方針(COA)比較など、決心の代替案(decision alternatives)の評価に関連するプロセスは、AI/MLツールの集約的な使用に適している。

インセンティブ(Incentives)。インセンティブは行動変容を促し、個人と組織の目標を整合させることで、任務の有効性を確保する。国防総省(DOW)がAI/MLツールを意思決定に幅広く導入しようとする場合、リーダーはインセンティブとディスインセンティブが組織のパフォーマンス、特に変化の受容性に与える影響を慎重に評価する必要がある。現状維持は変化に対する敵対的なものとして作用し、進歩に必要な変化への抵抗を生み出す、根深い組織習慣として現れる[44]。

抵抗は個人的または組織的なものであり得る。個人の抵抗には、悪意のあるものもあれば、そうでないものもある。悪意のある抵抗者は、自己価値を維持するために積極的に障害を作り出し、多くの場合、新興技術によって組織内での地位が奪われるのではないかという恐怖に駆られる。一方、悪意のない抵抗者は、単に変化への理解が不足しているため、慣れ親しんだ慣習から一歩踏み出すことを躊躇する場合がある[45]。

2024年2月23日、カリフォルニア州キャンプ・ペンドルトンで、プロジェクト・コンバージェンス・キャップストーン4の一環として、自律型低姿勢船がデル・マー・ボート・ベイスンで航行し、その能力をテストした。 (米海兵隊/ケビン・レイ・J・サルバドール(Kevin Ray J. Salvador)撮影)。 |

組織的な抵抗は、いくつかの形で現れる可能性がある。第一に、社会的・文化的な抵抗は、伝統的な手法に対する世代的な嗜好に起因する可能性がある。これは、AI/MLツールのリテラシー不足や、技術の潜在的な応用に関する誤解に起因する可能性がある。この抵抗は、勤続年数に基づく昇進制度によって意思決定権が単一世代に集中する国防総省(DOW)のような階層構造においてより顕著になる。第二に、倫理的・道徳的な批判は、AI生成コンテンツの使用における信頼性、真正性、そして潜在的な盗作への懸念を中心とした組織的な抵抗を生み出す。「AIシェイミング」※2、つまり倫理的な懸念、怠惰の認識、あるいは信頼の問題に基づいてAI/MLツールの使用を批判する行為は、組織内において水平方向にも垂直方向にも現れる可能性がある[46]。第三に、AI/MLツールが個人のスキル要件、雇用安定性(job security)、そして権限に与える影響に対する認識が、この抵抗の一因となっている可能性がある[47]。

※2 「AIシェイミング(AI shaming)」とは、画像、文章、コードなどの制作にAI(人工知能)を使用した個人や企業に対して、「手抜きだ」「不誠実だ」「創造性がない」といった非難を浴びせたり、公然と辱めたりする行為を指す。2024年から2025年にかけて急速に広まった言葉で、単なる技術批判を超えて、AI利用者に対する「バッシング」や「社会的制裁」に近いニュアンスを含んでいる。

それぞれの抵抗のカテゴリーには、現状維持を主張する者が存在する可能性が高い。統合の指導者(Joint leaders)は、変化を促す適切なインセンティブを提供することで、その行動に影響を与える必要がある。例えば、従来のツールを好む上級准尉、安全保障への影響を懸念する下士官、職務の陳腐化を懸念する参謀、あるいはAIで生成された製品を信用せず、効率への影響に関わらず集中的な人員配置(staff labor)を要求する将官などがその例である。

この抵抗を克服するには、インセンティブに対するバランスの取れたアプローチが必要である。構造やプロセスの変更は具体的な障害に対処できるが、根深い習慣を克服するには、インセンティブに細心の注意を払う必要がある。インセンティブには、外発的なもの(報酬、昇進、表彰など)と内発的なもの(仕事の満足度、やりがいのある仕事、個人の充実感など)がある[48]。外発的インセンティブはAI/MLツールの早期導入を促進する可能性があるが、内発的インセンティブは最終的に長期的な変革に必要な組織文化を形作る。

内発的インセンティブは、個人と組織の成長と発展に様々な機会をもたらす。例えば、AI/MLツールは、様々な分野における個人およびグループの研究効率を向上させ、結果として製品開発のタイムラインを合理化する可能性がある。さらに、人間と機械の協業(human-machine collaboration)により、組織は双方の創造性と計算能力の強みを活用できるようになり、迅速なデータ分析と創造的な問題解決を促進する。最後に、教育と研修を通じて自己バイアスを軽減することで、組織内に成長志向の文化が育まれる。このような文化は、さらなるイノベーションを引き出し、変化を正常化し、個人と組織を一致した到達目標へと導く内発的インセンティブを高める。

外発的インセンティブと内発的インセンティブの組み合わせは、組織が経験する抵抗の種類に合わせて調整する必要がある。しかしながら、組織は望ましい行動を促すためにどのようなインセンティブ・レバーを活用できるかという制約を受ける可能性がある。そのため、統合の指導者(joint leaders)は、組織の成長と変革を促進し、AI/MLツールの広範な導入を実現するために、適切な影響力ツールを特定するという課題に直面している。

リーダーシップとマネジメント(Leadership and Management)。組織のリーダーシップとマネジメントは、AI/MLツールを意思決定に導入する組織デザイン要因に大きく影響する。しかし、統合の指導者(joint leaders)は、AI/MLツール導入のための他の組織デザイン要因を効果的に適応させる前に、まず自らのAI/MLリテラシーを高める必要がある。AI/MLの機能と限界を理解していないと、リーダーはこれらのツールに過度に依存したり、懐疑的な見方から十分に活用しなかったりするリスクがある[49]。例えば、AI/MLを活用した決心支援ツール(AI/ML-enabled decision aids)を活用することで戦場での有効性を高めることができるが、それは指揮官がAI/MLツールの提案を解釈し、その出力を信頼できる場合に限られる。

個人のAI/MLリテラシーを育成するだけでなく、統合の指導者(joint leaders)は、変革に向けた説得力のあるビジョンと、それを実現するための明確な道筋を明確に示さなければならない[50]。このコミュニケーションは、積極的な反対ではなく、理解不足に起因することが多い、悪意のない抵抗に対処する上で特に重要である。リーダーは、AI/ML導入に対する抵抗が組織ごとに異なる形で現れることを認識し、遭遇する抵抗の種類に応じて、それぞれに適したインセンティブを策定する必要がある。成長志向の組織文化を醸成するリーダーは、より直接的なインセンティブを強力に補完する。このような文化は、成果の向上がAI/MLツールの価値を実証し、導入を標準化するにつれて、自己強化的なものになる[51]。

統合の指導者(Joint leaders)は、組織デザイン要因が部隊におけるAI/MLの導入にどのような影響を与えるかを体系的に評価する必要がある。人材に関しては、「検索エンジン思考(search-engine thinking)」からAI/MLツールのインタラクティブな活用方法を理解するための思考へと転換するための研修イニシアチブを推進することを意味する。また、人間とAIの協業(human-AI collaboration)を最適化するための迅速なエンジニアリングや反復技術といった新しいスキル・セットを開発するための研修イニシアチブを推進することも意味する。任務と環境が柔軟性を許容する場合、統合の指導者(joint leaders)は、より迅速かつ広範な情報に基づいた意思決定を通じて任務を達成するためのAI/ML導入をより効果的に促進するための構造的選択肢を検討する必要がある。これは一般的に、意思決定を組織の末端(the edges of an organization)にまで押し下げ、組織をフラット化することで機能横断的な協業(cross-functional collaboration)、反復、AI/MLツールの並行利用を促進することを意味する。そのために、統合の指導者(joint leaders)は組織内でどのような決心がどこで行われているかを評価し、AI/MLツールの活用を最適化するための組織再編を行う必要がある。必要に応じて、指揮命令関係が階層構造を左右することもある。統合の指導者(Joint leaders)は、AI/MLツールの有効性を最大化するために、垂直的分権化(vertical decentralization)および水平的分権化(horizontal decentralization)の機会を特定する必要がある。プロセスにおいては、統合の指導者(joint leaders)は、決心サイクル(decision cycles)に繋がる情報フローにAI/MLツールを導入するよう導き、どのフローが完全自動化またはハイブリッド・アプローチのメリットを享受できるかを特定する必要がある。最終的には、統合の指導者(joint leaders)は、AI/MLツールの導入には、あらゆる組織デザイン要因における同期した適応が必要であることを認識する必要がある。

リーダーシップとマネジメントは、組織デザインの要因を形成する上で非常に重要な役割を果たす。これらの要因の組み合わせが、組織のパフォーマンスと文化を左右する。AI/MLの導入に向けて組織を積極的に適応させない統合の指導者(joint leaders)は、戦略的優位性を損なう旧来の意思決定モデルに縛られた統合部隊になってしまうリスクがある。

結論

現代戦(modern warfare)において、決心の支配性(decision dominance)は勝利と高い相関関係にある。AI/MLツールは、決心のスピードと精度を向上させることで、戦場の様相を一変させている。国防総省(DOW)にとって、これらのツールを効果的に導入しないことは、作戦テンポの遅延(slower operational tempo)、認知負荷(cognitive overload)の増加、インテリジェンスの盲点が高くなる可能性(a higher probability of intelligence blind spots)、部隊の即応性の低下(reduced force readiness)など、深刻な結果をもたらす[52]。

この分析により、AI/MLツールの広範な統合は、技術力とアクセスだけでなく、AI/MLツールの導入に影響を与える組織デザイン要因にも左右されることが明らかになった。時代遅れの人間の認知習慣、組織内の抵抗、そして旧来の意思決定プロセスに深く根ざした現状を打破するために、国防総省(DOW)は人材、構造、プロセス、インセンティブ、そしてリーダーシップとマネジメントを変革する必要がある。

喫緊の課題は明白である。国防総省(DOW)は意思決定へのAI/MLツールの導入を加速させなければならない。そうしなければ、AI/MLツールをより効果的に運用するために兵器化する敵対者に、統合部隊が追い抜かれる危険性がある。これらのツールは決心の連続体(the decision continuum)においてさらに左へと進むにつれて、問題の枠組み、選択肢の生成、そして行動の選択方法をますます左右するようになる。人間の判断は依然として重要な役割を果たしており、同時に進化していく必要があるが、進歩の足かせとなってはならない。つまり、AI/MLを迅速に導入しなければ、陳腐化を招き、それは合衆国の国家安全保障にとって容認できない選択肢となる[53]。JFQ

ノート

[1] マリー・モレール(Marie Morelle)他著「Towards a Definition of Cognitive Warfare」、HAL Open Science、2023年12月7日、防衛のための人工知能会議、DGA Maîtrise de l’Information、2023年11 月、フランス、レンヌ、https://hal.science/hal04328461v1/document。

[2] パトリック・タッカー(Patrick Tucker)著「中国がTikTok、AI、ビッグ・データをどのように利用して台湾の選挙をターゲットにしたか」、ディフェンス・ワン、2024年4月8日、https://www.defenseone.com/technology/2024/04/how-china-usedtiktok-ai-and-big-data-target-taiwanselections/395569/。

[3] ケビン・ポルペター(Kevin Pollpeter)、アマンダ・ケリガン(Amanda Kerrigan)著「人民解放軍(PLA)とインテリジェント戦争:予備的分析」、アンドリュー・イラチンスキー共著(バージニア州アーリントン:CNA、2021年10月)、https://www.cna.org/reports/2021/10/ThePLA-and-Intelligent-Warfare-A-PreliminaryAnalysis.pdf。

[4] サム・ランスボサム(Sam Ransbotham)他著「AIによる個人および組織の価値の実現」MIT Sloan Management Review、2022年10月31日、https://sloanreview.mit.edu/projects/achieving-individual-andorganizational-value-with-ai/。

[5] 「支払いの自由化(Payments Unbound)」、nd、2025年8月5日アクセス、https://www.jpmorgan.com/payments/payments-unbound/volume-3/smart-money; テオ・スタイン(Theo Stein)著「NOAA Researchが主力気象モデルのAI搭載兄弟モデルを開発」、NOAA Research、2025年7月22日、https://research.noaa.gov/noaa-research-develops-an-ai-powered-siblingto-its-flagship-weather-model/。

[6] キャシー・カオ(Kathy Cao)他著「認知戦への対抗:認識とレジリエンス」NATOレビュー、2021年5月20日、https://web.archive.org/web/20250211231319/ https://www.nato.int/docu/review/articles/2021/05/20/countering-cognitivewarfare-awareness-and-resilience/index.html。

[7] ニコラ・ド・ベルフォン(Nicolas de Bellefonds)他著「AI の価値はどこにあるのか?」 (ボストン: ボストン コンサルティング グループ、2024年10 月)、https://www.bcg.com/publications/2024/wheres-value-in-ai.

[8] コナー・グレナン(Connor Grennan)著「コナー・グレナン(Connor Grennan)が語る「検索エンジンの考え方」を超えて」、モーリー・ウッド(Molly Wood)によるインタビュー、Microsoft WorkLab、2025年1月7日、ポッドキャスト音声、26:50、https://www.microsoft.com/en-us/worklab/podcast/conor-grennan-on-moving-beyondthe-search-engine-mindset。

[9] ベルフォン(Bellefonds)他著「AI の価値はどこにあるのか?」

[10] ルディ・ルイテンバーグ(Rudy Ruitenberg)著「最速の者の生き残り: 軍のリーダーは AI の解放と制御を目指す」、Defense News、2025年2月13日、https://www.defensenews.com/global/europe/2025/02/13/survival-of-the-quickestmilitary-leaders-aim-to-unleash-control-ai/。

[11] ルイテンバーグ(Ruitenberg)著「最速のものの生存」

[12] ジェイ・R・ガルブレイス(Jay R. Galbraith)著「ビッグ・データに起因する組織デザインの課題」、Journal of Organization Design 3、第1号(2014年)、2~13、http://dx.doi.org/10.7146/jod.8856。

[13] ジェイ・R・ガルブレイス(Jay R. Galbraith)著「組織をデザインする:事業部門レベルおよび企業レベルの戦略、構造、プロセス(Designing Organizations: Strategy, Structure, and Process at the Business Unit and Enterprise Levels)」、第3版(ホーボーケン、ニュージャージー州:Jossey-Bass、2014年)、52-3ページ。

[14] ガルブレイス(Galbraith)著「組織をデザインする」 22-3頁。

[15] ガルブレイス(Galbraith)著「組織をデザインする」37-8頁。

[16] ガルブレイス(Galbraith)著「組織をデザインする」44頁。

[17] ガルブレイス(Galbraith)著「組織をデザインする」22-3頁。

[18] ジェイ・R・ガルブレイス(Jay R. Galbraith)著「スター・モデル(The Star Model)」、nd、4-5、https://jaygalbraith.com/services/star-model/。

[19] ケイシー・ヘンリー(Casey Henley)著「神経科学の基礎」(イースト・ランシング:ミシガン州立大学図書館、2021年)、349-353ページ、https://openbooks.lib.msu.edu/neuroscience/。

[20] コナー・グレナン(Connor Grennan)は自身の講義で「検索エンジン・マインドセット」という用語を使用している。「プロフェッショナルのための生成AI:優位性をもたらす戦略的フレームワーク」AI Mindset、https://www.ai-mindset.ai/gen-ai-for-professionals を参照されたい。また、「コナー・グレナン(Connor Grennan)の「検索エンジン・マインドセット」を超えて」、モーリー・ウッド(Molly Wood)によるインタビューも参照されたい。

[21] ファブリツィオ・デル・アクア(Fabrizio Dell’Acqua)他著「ギザギザの技術フロンティアをナビゲート:AIがナレッジワーカーの生産性と品質に及ぼす影響に関するフィールド実験的証拠」SSRN学術論文番号4573321(Social Science Research Network、2023年9月15日)、https://doi.org/10.2139/ssrn.4573321。

[22] 「プロフェッショナル向けの生成AI」

[23] 「AI Rapid Capabilities Cell」、国防総省デジタル・人工知能局長、2025年2月20日アクセス、https://www.ai.mil/Initiatives/AI-Rapid-Capabilities-Cell/。

[24] AIを使わないユーザーは、従来型の人間主導のワークフローにのみ依存していたため、生産性が低下した。AIを訓練を受けていないユーザーと組み合わせると、生産性は向上したが、不適切なタスクにAIを依存したためにエラーが増加しやすくなった。訓練を受けたユーザーと組み合わせると、AIは反復的なプロンプトを活用して出力を洗練させ、AIの能力と人間の直感のバランスをとることでタスクのパフォーマンスを最適化した。デル・アクア(Dell’Acqua)他著「ギザギザの技術フロンティアをナビゲートする」を参照。

[25] 意思決定の複雑さは、考慮される情報の幅、出力の解釈要件、選択肢の生成、時間的制約、そして再現性の必要性によって変化する。Yash Raj Shrestha他「人工知能時代の組織的意思決定構造」、California Management Review 61, no. 4 (2019), 1, https://doi.org/10.1177/0008125619862257を参照。

[26] シュレスタ(Shrestha)他著「人工知能時代の組織の意思決定構造」5、9-10。

[27] デル・アクア(Dell’Acqua)他著「ギザギザの技術フロンティアをナビゲートする」

[28] デル・アクア(Dell’Acqua)他著「人工知能時代の組織の意思決定構造」12ページ。

[29] ヘンリー・ミンツバーグ(Henry Mintzberg)著「組織デザイン:流行か適合か?」ハーバード・ビジネス・レビュー、1981年1月1日、https://hbr.org/1981/01/organization-design-fashion-or-fit.

[30] リチャード・ファーネル(Richard Farnell)とキラ・コフィー(Kira Coffey)著「戦争計画策定におけるAIの新たなフロンティア:AIエージェントが軍事上の意思決定に革命を起こす方法」ハーバード・ケネディスクール・ベルファー科学国際問題センター、2024年10月11日、https://www.belfercenter.org/researchanalysis/ais-new-frontier-war-planning-how-aiagents-can-revolutionize-military-decision.。

[31] マシュー・ベルーベ(Mathieu Bérubé)他著「組織におけるAI導入の障壁:デルファイ調査の結果」、2021年ハワイ国際システム科学会議発表論文、https://doi.org/10.24251/HICSS.2021.805。

[32] ミンツバーグ(Mintzberg)著「組織デザイン」

[33] ミンツバーグ(Mintzberg)著「組織デザイン」

[34] エイミー・ケイツ(Amy Kates)、ジェイ・R・ガルブレイス(Jay R. Galbraith)著「あなたの組織をデザインする:STARモデルを使用して5つの重要なデザイン課題を解決する」(Hoboken、NJ:Jossey-Bass、2007年)、17、http://ebookcentral.proquest.com/lib/nationaldefense-ebooks/detail.action?docID=315230。

[35] ケイツ(Kates)とガルブレイス(Galbraith)著「あなたの組織をデザインする」、37 ページ。

[36] ケイツ(Kates)とガルブレイス(Galbraith)著「あなたの組織をデザインする」4 ページ。

[37] 「ジョン・ボイドとOODAループ」Psych Safety、nd、2025年2月20日アクセス、https://psychsafety.com/john-boyd-and-the-ooda-loop/。

[38] 統合出版物5-0、「統合計画策定(Joint Planning)」(ワシントンD.C.:統合参謀本部、2024年7月1日)、III–10。

[39] 統合計画策定プロセス(JPP)の7つのステップは、計画策定の開始、任務分析、行動方針(COA)の策定、行動方針(COA)分析とウォーゲーミング、行動方針(COA)の比較、行動方針(COA)の承認、および計画または命令の策定である。

[40] トーマス・W・スパー(Thomas W. Spahr)著「レイヴン・セントリー(Raven Sentry):アフガニスタンにおける兆候と警告のためのAIの活用」、Parameters 54、第2号(2024年)、https://press.armywarcollege.edu/parameters/vol54/iss2/9/。

[41] ジャスティン・ダブルデイ(Justin Doubleday)著「ペンタゴン、主力人工知能イニシアチブであるプロジェクト・メイヴン(Project Maven)をNGAに移行」、2022年4月26日、https://federalnewsnetwork.com/intelligencecommunity/2022/04/pentagon-shiftingproject-maven-marquee-artificial-intelligenceinitiative-to-nga/。

[42] 赤十字国際委員会(ICRC)とジュネーブ国際人道法・人権アカデミー、「武力紛争における武力行使の軍事的意思決定における人工知能と関連技術」(ジュネーブ:ICRC、2024年3月)、https://www.icrc.org/en/publication/expertconsultation-report-artificial-intelligence-andrelated-technologies-military。

[43] ファーネル(Farnell)とコフィー(Coffey)著「戦争計画におけるAIの新たなフロンティア」

[44] トム・ガルビン(Tom Galvin)著「軍事組織における変革の主導:上級リーダー向け入門書」(ペンシルバニア州カーライル:米国陸軍戦争大学、2018年)、97、https://apps.dtic.mil/sti/citations/AD1124769。

[45] ガルビン(Galvin)著「軍事組織における変革を主導する」 97 ページ。

[46] ルイ・ジライ(Louie Giray)著「AI の非難:学術論文執筆者と研究者の間の沈黙の汚名」、Annals of Biomedical Engineering 52、no. 9 (2024)、2319、https://doi.org/10.1007/s10439-024-03582-1。

[47] ジライ(Giray)著「AI Shaming」、2320–21。

[48] ガルブレイス(Galbraith)著「組織をデザインする」44頁。

[49] ベルーベ(Bérubé)他著「組織におけるAI導入の障壁」

[50] ガルビン(Galvin)著「軍事組織における変革の主導」 98 ページ。

[51] エドガー・H・シャイン(Edgar H. Schein)著「組織文化とリーダーシップ」第4版(ホーボーケン、ニュージャージー州:ジョッセイバス、2010年)。

[52] デビッド・ヴァーガン(David Vergun)著「AIは米国の戦場での優位性をもたらすと将軍が語る」米国国防総省、2019年9月24日、https://www.defense.gov/News/NewsStories/Article/Article/1969575/ai-to-giveus-battlefield-advantages-general-says/。

[53] 本研究の準備中、研究チームはChatGPT 4.0、Claude、Perplexityを用いてアウトライン作成、構成、校正を行った。その後、研究チームは内容を徹底的にレビューし、必要に応じて編集した。